La inteligencia artificial (IA) es el principal tema tecnológico hoy en día. La irrupción pública del ChatGTP, a finales del año pasado, provocó una amplia conversación mundial por sus implicaciones positivas y negativas. Hoy, la IA dejó de ser una promesa para convertirse en una realidad.

Recordemos, de acuerdo con Wikipedia, que la IA, “en el contexto de las ciencias de la computación, es una disciplina y un conjunto de capacidades cognoscitivas e intelectuales expresadas por sistemas informáticos o combinaciones de algoritmos cuyo propósito es la creación de máquinas que imiten la inteligencia humana para realizar tareas, y que pueden mejorar conforme recopilan información”. Imitan y pueden, incluso, mejorar la inteligencia humana.

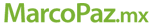

El gran debate está en sus alcances y control. En marzo de este año, un grupo de cientos de expertos y científicos mundiales firmaron una carta para proponer una pausa de seis meses en la investigación sobre IA, bajo la advertencia de que se corren grandes riesgos para la humanidad.

“En la petición publicada en el sitio futureoflife.org piden una moratoria hasta que se establezcan sistemas de seguridad con nuevas autoridades reguladoras, vigilancia de los sistemas de IA, técnicas que ayuden a distinguir entre lo real y lo artificial, e instituciones capaces de hacer frente a la ‘dramática perturbación’ económica y política (especialmente para la democracia) que causará la IA” (https://bit.ly/3M0AUOu).

Quienes están a favor de la regulación, esgrimen entre sus principales razones (con apoyo de https://chat.openai.com):

- Seguridad: La IA puede ser muy poderosa y tener un impacto significativo en nuestras vidas. Si no está bien regulada puede representar una amenaza para la seguridad pública y privada. La IA también puede ser vulnerables a ataques de hackers o ser utilizada de manera maliciosa por personas con intenciones maliciosas. Puede hacer mucho bien, pero también mucho mal.

- Ética: La IA puede tomar decisiones que afectan a las personas y la sociedad en general. Por lo tanto, es importante que las disposiciones que tomen sean éticas y justas. Se buscaría que la regulación garantice la no discriminación ni el perjuicio a diferentes grupos de personas.

- Transparencia: La IA puede ser muy compleja y difícil de entender. Por lo tanto, es importante que los usuarios sepan cómo funciona y cómo se toman las decisiones. La regulación puede garantizar que la IA sea transparente y comprensible para el público.

- Responsabilidad: Si la IA causa daño, es importante que haya alguien responsable de ello. La regulación puede garantizar que las empresas y organizaciones que utilizan IA sean responsables de sus acciones.

Pero también hay quienes no están de acuerdo en su regulación, con otros argumentos:

- El equilibrio entre innovación y seguridad: Algunos argumentan que la regulación excesiva de la IA puede limitar la innovación y el progreso tecnológico. Otros aducen que la falta de regulación puede poner en riesgo la seguridad pública y privada. Encontrar el equilibrio adecuado entre estos dos objetivos es un tema de controversia.

- Complejidad: La IA puede ser muy compleja, y algunas personas argumentan que la regulación puede ser difícil de implementar y hacer cumplir. Puede ser difícil para los reguladores entender cómo funciona la IA y determinar qué regulaciones son necesarias.

- Costo: La implementación de regulaciones puede ser costosa, tanto para las empresas que utilizan la IA como para los reguladores encargados de hacer cumplir las regulaciones. Algunas personas argumentan que los costos de la regulación pueden ser mayores que los beneficios, y significar costosas barreras de entrada para nuevas empresas.

- Libertad de expresión: Algunas personas señalan que la regulación de la IA puede limitar la libertad de expresión y el acceso a la información. Si se regulan ciertos tipos de IA, podría haber restricciones en la forma en que se utiliza la tecnología para recopilar, analizar y compartir información.

Por su parte, Geoffrey Hinton, padrino de la inteligencia artificial, quien recientemente renunció a Google para dedicarse a advertir al mundo de los riesgos de la IA, mencionó tres grandes peligros en el corto plazo: “La creación de contenido digital cuya veracidad será imposible de comprobar para el usuario promedio”, el reemplazo de trabajadores en una amplia gama de oficios y que los sistemas de IA se conviertan un día en armas autónomas, especies de “robots asesinos” (https://bbc.in/3nSNJ5A).

La IA ya está aquí y ha desatado una acelerada competencia por su uso masivo por parte de las grandes plataformas tecnológicas. Otra vez, en el ámbito digital, las reglas se quedan atrás. El debate continúa, pero sin consensos. Mientras tanto las aplicaciones de la IA avanzan. ¿Llegaremos a tiempo con la regulación?